Aufsteiger

Es hatte sich bereits in den letzten Wochen abgezeichnet, die Bildkopie-Galerie bild10.com steigt nun in die Bidox-Top-100 ein. Mit einem bidox von 25,8 und fast 600 Bildern schafft es die Domain auf Platz 81.

Das Rezept für diesen Erfolg ist immer noch recht einfach. Man kopiert einfach Bilder, die in der Bildersuche gut platziert sind, auf die eigene Seite und strickt ein paar automatische generierte Seiten drum herum. Martin Mißfeldt hatte das Problem auch kürzlich wieder in seinem TagSeoBlog thematisiert.

Der Aufstieg wird jetzt noch ein paar Woche so weiter gehen, bis Google eventuell doch mal etwas merkt. Allerdings nicht von alleine, sondern bestenfalls dann, wenn vielleicht ein Google-Mitarbeiter zufällig diesen Text hier liest oder jemand die Seite als Spam meldet.

Absteiger

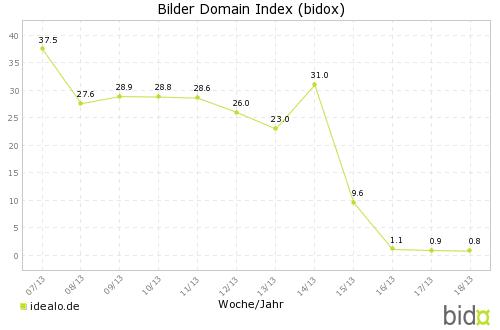

Auch nicht erst seit letzter Woche ging es für den Preisvergleicher idealo.de bergab. Mit einem bidox von 31 und knapp 2500 Bildern lag man vor fünf Wochen noch auf Platz 63. Jetzt ist Idealo mit nur noch 48 Bildern und einem bidox von 0,8 praktisch in der Bedeutungslosigkeit (Platz 4050) versunken.

Über die Gründe für so deutliche Einbrüche im bidox kann man oft nur spekulieren. Abstrafung durch Google, technische Probleme, Änderungen an der Seitenstruktur oder der Konfiguration?

Bei Idealo sind die Probleme tatsächlich hausgemacht, wie eine kurze „Untersuchung“ ergab. Die Bilder und andere Dateien (z.B. JavaScript) sind auf ein CDN cdn.idealo.com ausgelagert. Dort gibt es auch eine robots.txt Datei, die wie folgt aussieht:

User-Agent: * Disallow: / Allow: /*produktbild_gross*

Eine durchaus sinnvolle Konfiguration, allen Bots alles zu verbieten und nur die großen Produktbilder zur Indexierung frei zu geben.

Allerdings heißen die großen Bilder seit einiger Zeit nicht mehr *produktbild_gross*, sondern *produktbild_max*. Deshalb werden die so umbenannten oder neuen Produktbilder von den Bots korrekterweise ignoriert.

Das Problem ist mit einer Anpassung der robots.txt leicht zu beheben. Scheinbar sind aber die Besucherzahlen über die Bildersuche bei Idealo nicht wirklich signifikant und so hat es wohl dort noch niemand bemerkt.

Auf und Ab

Nicht immer sind die Gründe für das Auf und Ab einer Domain im bidox so einfach zu erklären, wie in den obigen Beispielen. Auf jeden Fall sollte man aber bei Änderungen an der Seitenstruktur auch immer eine Blick in die beteiligten robots.txt-Dateien werfen, um eventuelle, so nicht beabsichtigte Effekte zu vermeiden.