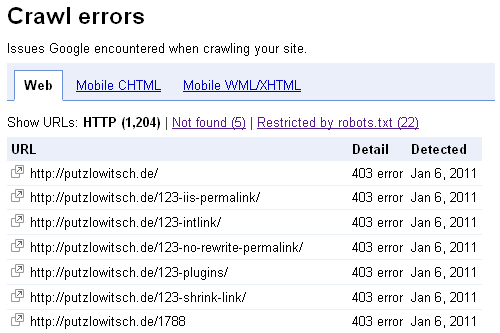

Nun gab es von Google die Quittung für den Ausfall der Putzlowitscher Zeitung am 5. Januar 2011. In den Webmastertools werden mir derzeit gut 1200 Fehler mit dem Statuscode 403 (Forbidden) angezeigt:

Ein Umzug mit Verzug

Am 5. Januar war der Google-Bot zuletzt gegen 1.30 Uhr bei putzlowitsch.de zu finden. Dann erfolgte seitens des Webhosters der Umzug auf einen neuen Server und somit bekamen alle dort gehosteten Seiten eine neue IP-Adresse. Für die dort registrierten Seiten war das auch kein Problem, nach kurzer Zeit waren die DNS-Server aktualisiert und Besucher und Suchmaschinenbots bekamen die Seiten wieder normal zu sehen.

Einige Seiten, die bei anderen Anbietern liegen, werden aber per DNS-A-Record auf den Webspace beim umgezogenen Server umgeleitet und da stimmte die IP-Adresse dann nicht mehr, weil diese Einträge nicht automatisch aktualisiert werden.

Gegen 7 Uhr hatte ich das bemerkt und zunächst den Eintrag für meine wichtigste Seite, die „Putzlowitscher Zeitung“, angepaßt. Im Laufe des Vormittags hatte sich dann auch fast alles wieder eingerenkt, die normalen Besucher und z.B. der Yahoo-Bot (gegen 8.30 Uhr) und der Bing-Bot (gegen 9.30 Uhr) kamen wieder auf die Seite.

Nur der Googlebot ließ sich nicht blicken. Erst am 6. Januar hat er gegen 2.30 Uhr wieder die Putzlowitsch-Seite besucht. Ungünstigerweise ist er außerdem noch in meine Bot-Falle getappt, denn auch die robots.txt war für ihn mehr als 24 Stunden nicht abrufbar. Somit gab es aus Sicht des Google-Bots keinerlei Zugriffsbeschränkungen.

Abgewertet, ersetzt und rausgeschmissen

Seit gestern verabschieden sich so langsam auch einige meiner Seiten, besonders Bilder, aus den Google-Suchergebnissen.

Seit gestern verabschieden sich so langsam auch einige meiner Seiten, besonders Bilder, aus den Google-Suchergebnissen.

Dabei kann man drei unterschiedliche Ergebnisse sehen. Im einfachsten Fall werden die Bilder zunächst nur um ein paar Plätze im Ranking abgewertet. Je nach Position hat das auch die Verschiebung auf eine hintere Trefferseite zur Folge. Vermutlich ist das aber nur ein Zwischenschritt zum zweiten und dritten Fall.

Falls es eine identische Kopie oder das Bild in einer weiteren Version auf einer anderen Webseite gibt, wird nun die Kopie angezeigt, aber an einer schlechteren Trefferposition. So ist das z.B. bei der Kartoffel der Fall (siehe Screenshot). Mein Kartoffelbild lag in den letzten Wochen recht konstant auf Platz vier, die Kopie wurde nun an Position 8 einsortiert. Interessanterweise wird bei der Suche nach „Ähnlichen Bilder“ aber weiterhin meine Kartoffel angezeigt.

Im schlimmsten Fall sind Bilder ganz aus den Suchergebnissen verschwunden. So ist es z.B. den Kartoffeln, der Karotte und der Möhre ergangen.

Positiv denken

Etwas Gutes hat die Sache natürlich. So kann man mal sehen was passiert, wenn plötzlich gut rankende Bilder gesperrt werden und wo es eventuell noch andere Kopien der Bilder gibt. Der Witz ist, daß ich genau so etwas gerade als kleines Experiment in Angriff nehmen wollte, allerdings nicht in dieser Breite mit so vielen Bildern. :-)

Leider ist auch mein Bilder-SERPs-Überwachungstool noch nicht ganz fertig, so daß ich nun ständig „manuell“ nachgucken muß, was mit den Bildern passiert. Ich bin auch mal gespannt, wann sich alles wieder normalisiert. Dann könnte ich ja nochmal mit meinem eigentlichen Experiment durchstarten.