Google auf Abwegen

Vor knapp einem halben Jahr hatte ich bereits berichtet, daß Google Links folgt, die gar keine sind. Irgendwer schrieb da auch in den Kommentaren, daß es vielleicht nur ein Test sein könnte. Gut möglich, Google probiert ja gerne mal Sachen aus. Ich erinnere mich noch an die ausgefüllten Suchformulare (/?s=suchbegriff) vor etwa vier Jahren. Das hatte sich dann irgendwann erledigt.

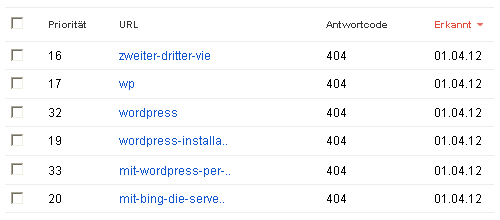

Die als URL interpretierten Texte landen aber weiterhin in den Google Webmastertools und natürlich auch in meinen Server-Logdateien. Das sind die neuen 404-Fehler vom 1. April:

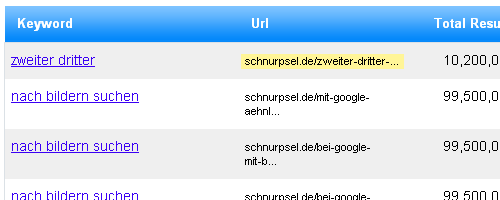

Und so sehen die „verlinkenden“ Seiten aus:

• webstatsdomain.com zur Domain „schnurpsel.de“

• pixitree.de mit „Installation Eigenen Domains WordPress“

• news.blogtotal.de mit „Modrewrite Ohne WordPress“

• link-fuchs.de mit „Aktuelle Ip Per Email Zu Verschicken Besonders“

• alllaws.org mit „Mit Bing Finden“

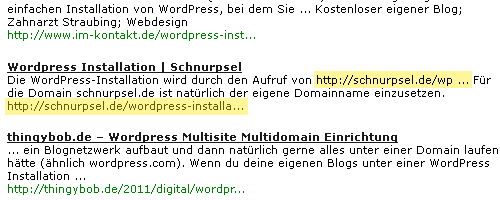

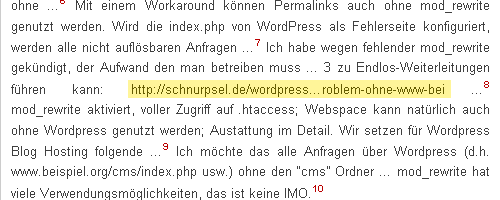

Mal davon abgesehen, daß die „verlinkenden“ Seiten fast allesamt als Suchmaschine getarnte Spam-Seiten sind, gibt es die von Google dort angeblichen gefundenen Links nicht. Das sind durchweg verkürzte, textliche Darstellungen von URLs, die mit drei Punkten enden.

So schwer ist das doch nicht

Nun weiß ich zwar nicht, wie Google diese Pseudolinks aus den Seiten extrahiert, aber jeder mittelmäßige Programmierer dürfte dazu in der Lage sein, die mit drei Punkten endenden, vermeintlichen Links im Algorithmus auszusortieren. Wenn das, was wie eine URL aussieht, mit … endet, ist es niemals nicht eine existierende URL, sondern nur eine verkürzte Darstellung einer solchen. Dann muß auch nicht der Google-Bot losgeschickt werden, um sich doch nur einen Error 404 Not Found abzuholen. Letztendlich hat das dann auch nichts bei den Crawling-Fehlern in den Webmastertools verloren.

Google, bitte nachbessern!

Google search quality highlights

Google veröffentlicht seit einiger Zeit (Dezember 2011?) Neuigkeiten aus dem Bereich „Verbesserung der Suchqualität“. Vielleicht habe ich da was übersehen, aber zur Erkennung von nicht existierenden Links war mir bisher nichts aufgefallen. Zumindest besteht da Verbesserungsbedarf.

Die Lösung des Problems wäre mein nächstes, ganz persönliches „Search quality highlight“. :-)

Ich ärgere mich schon seit längerem darüber und kann auch nicht nachvollziehen, warum G das nicht in den Griff bekommt.

Es ist noch schlimmer leider…

Wenn du irgendwo (zB in Javascript) auf deiner Seite Variablen wie folgt befüllst, ruft Google das auch auf

var1 = „/lalelu“

Und meinedomain.de/lalelu liefert mir natürlich einen 404…

Das ist ja gruselig, mit Javascript hatte ich das noch nicht. Irgendwie geht Google da zu weit, man kann es auch übertreiben.

Jetzt bin ich ja mal gespannt, wann ich bei mir den /lalelu Fehler zu sehen bekommen. :-)

Das ist ja schon seit längeren bekannt, dass Google seine Vormachtstellung in Deutschland ausnutzt. Ist schon ärgerlich das es keine wirkliche Konkurrenz zu google gibt.

Ich habe diesen Beitrag mit Freude gelesen. Gefreut hat mich, dass ich mit meinem Ärger nicht allein bin.

„… jeder mittelmässige Programmierer dürfte dazu in der Lage sein …“: aber sicher.

Wenn ich die „Fehler“ in den WMT „als korrigiert“ markiere, erscheinen sie nach wenigen Wochen wieder.

Was ich auch nicht verstehe: warum kann Google einen 410er nicht von einem 404er unterѕсhеidеn? Bing Webmaster Tolls kann das.