IP-Adressen, DNS und DNS-Cache

Wenn jemand meine Schnurpsel-Seite besuchen will, gibt er einfach in der Adresszeile des Browers schnurpsel.de ein. Das Internet funktioniert aber mit IP-Adressen, so ist Schnurpsel z.B. unter der Adresse 81.169.145.149 zu erreichen. Damit der Name in eine IP-Adresse umgesetzt werden kann, gibt es das DNS (Domain Name System) und entsprechende Server, die die Auflösung der Namen übernehmen.

Damit nun der Server nicht jedesmal neu befragt werden muß, werden bereits aufgelöste Namen zwischengespeichert. Einerseits verfügen viele Beriebssysteme über so einen DNS-Cache, teilweise sogar die Browser selbst und auch mein nigelnagelneuer DSL-ISDN-WLAN-Router hat einen solchen DNS-Cache.

Ein Blick in den DNS-Cache

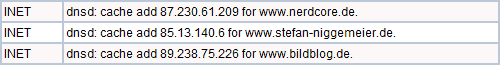

Normalerweise bin ich nicht ständig im DNS-Cache zugange, aber so einem neuen Router schaue ich anfangs gern mal auf die Finger. Im Systemprotokoll wird auch brav vermerkt, was der Router gerade so treibt. Etwas verwundert war ich über die zahlreichen Einträge „dnsd: cache add…“.

Da tauchten plötzlich Seiten wie Nerdcore, Stefan Niggemeier, BILDblog, netzwertig.com, CARTA und weitere auf, die ich in den letzten Minuten garantiert nicht besucht hatte. Aber irgendwie kam mir die Liste bekannt vor.

Und richtig, ich hatte kurz vorher bei zusammen.gerech.net einen Blick auf die aktuelle Blog-Top-100 geworfen. Da stehen sie alle in der Liste, nur hatte ich keinen der Links dort angeklickt. Sollte etwa der Firefox…

Der Firefox schaut voraus

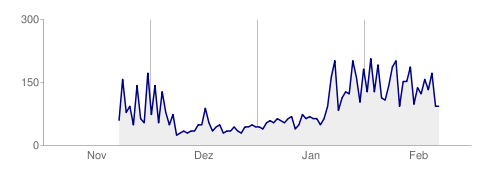

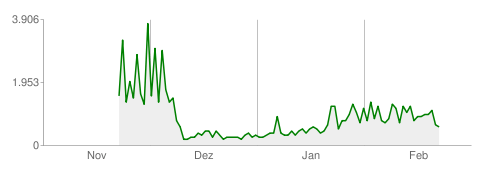

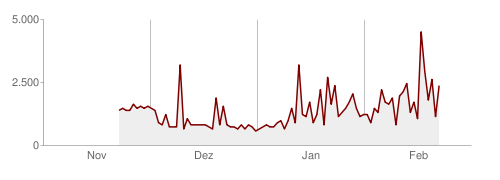

Seit Firefox 3.5 gibt es ein sogenanntes DNS-Prefetching, der Firefox macht also für alle auf der Seite gefunden Links eine DNS-Abfrage für die verlinkten Seiten. Das soll etwas mehr Geschwindigkeit bringen. Falls der Nutzer einen der Links anklickt, ist die IP-Adresse schon bekannt und es kann sofort losgehen.

Wenn der Nutzer aber keinen der 100 Links anklickt, wurden 100 unnütze DNS-Abfragen getätigt und 100 Einträge im DNS-Cache belegt, die keiner braucht. Der DNS-Cache meines Routers faßt in der Standardeinstellung übrigens genau 100 Einträge. Alles einmal mit Quark gefüllt.

DNS-Prefetching abschalten

Netterweise kann man im Firefox das DNS-Prefetching abschalten, aber nicht etwa in den Konfigurations-Dialogen, sondern durch einen beherzten Systemeingriff mittels about:config. Wie es geht und viele weitere Einstellmöglichkeiten findet man z.B. bei mozillaZine.

Kreativ und originell bloggen

Beim aktuellen Webmaster-Friday geht es um „Kreativ und originell bloggen: was inspiriert Euch?„. Das kann ich für schnurpsel.de recht einfach beantworten. Dieses Blog wird von Beobachtungen, Betrachtungen und Problemen rund um die Themen Internet, Technik, Suchmaschinen, WordPress, Webhoster und ähnlichen getrieben. Das gab, gibt und wird es sicher noch lange geben (siehe oben :-)).