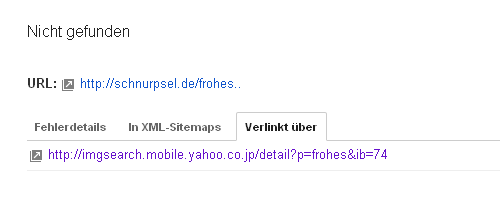

Fehlermeldung aus den Google Webmastertools:

„Der Googlebot konnte diese URL nicht crawlen, da keine zugehörige Seite existiert. Im Allgemeinen wirken sich 404-Codes nicht auf die Leistung Ihrer Website bei der Suche aus. Sie können sie jedoch zur Verbesserung der Nutzererfahrung verwenden.“

Zum einen ist das wieder mal kein Link, sondern nur eine verkürzte, textliche Darstellung. Ein Nutzer wird diesen „Link“ deshalb nie aufrufen, also muß ich auch nichts für die „Verbesserung der Nutzererfahrung“ tun. Der Link ist nur eine Google-Erfindung.

Viel interessanter ist meiner Meinung nach die angegebene Quelle des Links. Das sieht mir nach einer Suchergebnisseite der Yahoo-Bildersuche aus.

Ich dachte bisher immer, Google würde die Suchergebnisse der anderen großen Suchmaschinen nicht crawlen. Aber vielleicht ist es auch gar nicht so oder es war nur früher mal so oder ich bin einem Irrtum aufgesessen.

Gute Frage an was das liegt.Sihet aber schon etwas seltsam aus wie ich finden.

Also ich gehe fest davon aus, das alle Suchmaschinen ihre Möglichkeiten nutzen, um bei den anderen „abzuschauen“ allein um die eigenen Ergebnisse zu prüfen und Fehler etc. auszumerzen.

Was sie sich da genau anschauen und was sie da machen sei mal dahin gestellt.

Welche Suchmaschinen denn? Es gibt doch nur eine ;-) Zumindest keinen die man wahrnehmen kann.