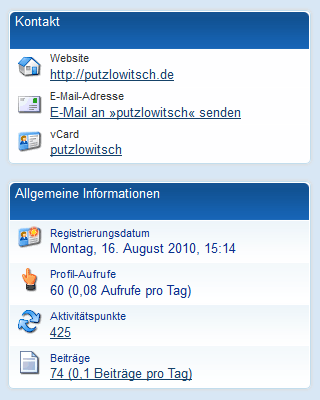

Heute habe ich mich nach längerer Zeit mal wieder im 1&1-Kundenforum eingeloggt und wie der Zufall es will, habe ich mich auf den Tag genau vor zwei Jahren dort registriert. So habe ich heute gewissermaßen mein 2jährigres Foren-Jubiläum, ein Grund zu feiern ist das für mich aber nicht.

Heute habe ich mich nach längerer Zeit mal wieder im 1&1-Kundenforum eingeloggt und wie der Zufall es will, habe ich mich auf den Tag genau vor zwei Jahren dort registriert. So habe ich heute gewissermaßen mein 2jährigres Foren-Jubiläum, ein Grund zu feiern ist das für mich aber nicht.

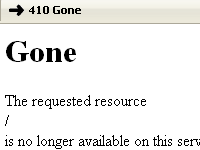

Der Anlaß meines Besuches im Forum ist nämlich die Nichterreichbarkeit fast aller meiner Domains, die bei 1&1 liegen. Zudem kann ich über die 1&1-E-Mail-Adressen nichts versenden oder empfangen.

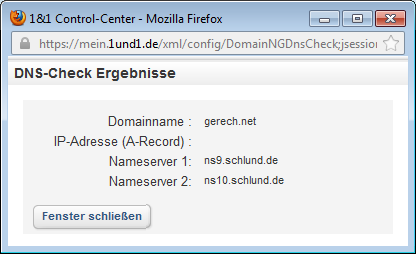

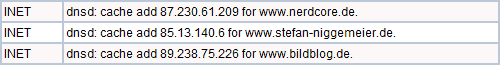

Grund ist ein Problem mit den DNS-Serveren, die für die Domains keine IP-Adressen zurückliefern, so als gäbe es die Domains nicht. Im 1&1-Control-Center gibt es einen DNS-Check, der im Moment so etwas anzeigt:

Der Eintrag für den A-Record ist leer, der Domain ist also keine IP-Adresse zugeordnet. Auch einen MX-Record (für den E-Mail-Empfang) gibt es nicht. Die Domain schein also im Internet nicht mit irgendeinem Server verbunden zu sein, hängt gewissermaßen unerreichbar in der Luft.

Im Forum wurde mitgeteilt, daß an dem Problem gearbeitet wird und es auch schon eine Lösung geben soll. Das wird nach nunmehr fast 24 Stunden aber auch Zeit.

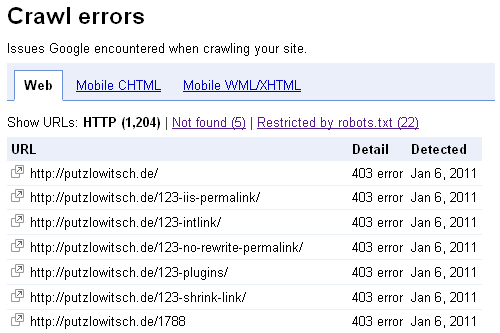

Gut, bei meinen paar Test-Seiten ist die Nichterreichbarkeit für einen Tag kein wirklicher Beinbruch. Wer allerdings seine geschäftliche Seite bei 1&1 hat und betroffen ist, wird da größere Problem haben. Nicht nur, daß die Webseite nicht erreichbar ist, nein, es ist auch keine E-Mail-Kommunikation mehr möglich.

Meine Idee von gestern Abend, einfach einen externen DNS-Server für eine 1&1-Domain einzutragen, hat lieder nichts genützt. Die veränderten Einstellungen werden mir im Control-Center zwar angezeigt, sind aber leider nicht wirksam.

Tja, da habe ich erst vor ein paar Tagen mein altes Hosting-Paket zu einem neuen Dual-Paket aufgestockt und dann sowas. Vielleicht sollte das Dualhosting nicht nur die doppelte Auslegung des Webservers umfassen, sondern auch die Absicherung der Nameserver.

Die Geo-Redundanz mit Spiegelug aller Daten und Prozesse meiner Website nahezu in Echtzeit in ein zweites Rechenzentrum nützt nichts, wenn die Seite dann doch wegen eines DNS-Problems nicht erreichbar ist.

Nachtrag: Als ich den Artikel hier fertiggestellt und veröffentlicht hatte, war das Problem gerade behoben worden.

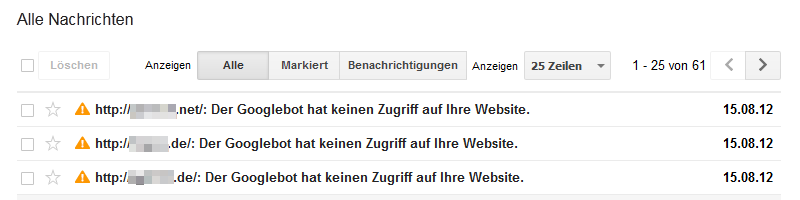

Nachtrag 2: Bei ein paar Ausfällen schlagen die Google-Webmaster-Tools noch nicht Alarm, aber wenn eine Seite länger nicht erreichbar ist, gibt es dann doch eine Meldung: